I guardrail dell’AI aiutano a garantire che gli strumenti di AI di un’azienda (e il loro utilizzo nel business) riflettano gli standard, le politiche e i valori dell’organizzazione stessa.

di Andrea Bondi

Tutti quanti abbiamo presente cosa siano i guardrail lungo le strade: barriere ai margini della carreggiata che proteggono i veicoli dal deviare dalla loro corsia e creare o finire in pericolo. Con l’avvento dell’AI generativa (Gen AI), il concetto di guardrail si applica anche ai sistemi progettati per garantire che gli strumenti di AI di un’azienda, specialmente i modelli linguistici di grandi dimensioni (LLM), funzionino in allineamento con gli standard, le politiche e i valori aziendali.

Il problema

Sebbene i sistemi di Gen AI possano migliorare l’efficienza, l’innovazione e il vantaggio competitivo di un’azienda, possono anche introdurre sfide e rischi, come informazioni imprecise o addirittura errate, o rischi per la sicurezza. I guardrail possono identificare ed eliminare contenuti imprecisi generati dai LLM, nonché monitorare e filtrare contenuti rischiosi quali: vulnerabilità di sicurezza, “allucinazioni” (contenuti generati dall’AI che sono fattualmente errati, inventati o fuorvianti, anche se sembrano plausibili o verosimili), contenuti “tossici” (linguaggio volgare, odio, pregiudizi, discriminazione, violenza…) o inappropriati e disinformazione.

Tuttavia, proprio come i guardrail sulle strade non eliminano il rischio di infortuni o morti, anche i guardrail dell’AI non garantiscono che i sistemi di AI siano completamente sicuri, equi, conformi ed etici.

Per i migliori risultati, le aziende possono implementare i guardrail dell’AI insieme ad altri controlli procedurali (ad esempio, trust framework dell’AI, software di monitoraggio e conformità, pratiche di test e valutazione), nonché una corretta infrastruttura tecnologica per le operazioni dell’AI, che scali la governance dell’AI in tutta l’organizzazione.

Quali sono i benefici dei guardrail dell’AI?

Per creare l’ambiente giusto per l’innovazione e la trasformazione della Gen AI è necessario garantire che la tecnologia possa operare in modo sicuro e responsabile, con i guardrail dell’AI che svolgono un ruolo critico.

Dato che i sistemi di AI sono suscettibili ad attacchi da parte di attori malintenzionati che sfruttano le vulnerabilità per manipolare i risultati generati dall’AI, i guardrail possono rafforzare i sistemi di AI contro tali attacchi, contribuendo a proteggere un’azienda e i suoi clienti.

Con l’aumento del controllo governativo sull’AI, le aziende devono garantire che i loro sistemi di AI siano conformi alle leggi ed agli standard esistenti e in evoluzione; aiutando un’azienda a mantenere la conformità alla Gen AI, i guardrail possono ridurre il rischio di sanzioni legali e responsabilità derivanti dall’uso di questi strumenti.

Infine, mantenere la fiducia con i clienti e il pubblico in generale è fondamentale per un’azienda: i guardrail consentono un monitoraggio continuo e una revisione dei contenuti generati dall’AI, riducendo il rischio che contenuti errati vengano rilasciati all’esterno dell’azienda.

Quali sono i principali tipi di guardrail per l’AI?

I guardrail sono suddivisi in base al loro scopo e ai tipi di rischi che affrontano, come ad esempio, rischi specifici di appropriatezza, allucinazione, allineamento e di validazione.

I guardrail di appropriatezza verificano se il contenuto generato dall’AI sia tossico, dannoso, parziale o basato su stereotipi e filtrano qualsiasi contenuto inappropriato prima che raggiunga i clienti; quelli di allucinazione garantiscono che il contenuto generato dall’AI non contenga informazioni errate o fuorvianti.

Invece, i guardrail di conformità normativa convalidano che il contenuto generato rispetti i requisiti normativi; mentre quelli di allineamento assicurano che il contenuto generato sia in linea con le aspettative dell’utente e non si discosti dal suo scopo principale (questi guardrail possono aiutare a mantenere la coerenza del marchio, ad esempio).

Vi sono infine i guardrail di validazione, che verificano che il contenuto generato soddisfi criteri specifici, cioè, che il contenuto contenga o non contenga determinate informazioni: se un contenuto generato viene segnalato da un guardrail di validazione, può essere indirizzato in un ciclo di correzione per risolvere l’errore.

La validazione dovrebbe essere l’ultimo di una serie di compiti svolti dai guardrail e, successivamente, un validatore umano dovrebbe esaminare i casi segnalati o ambigui che richiedono un ragionamento umano.

Cosa c’è sul mercato

Oggi sono disponibili sul mercato una varietà di librerie open-source affinché le aziende possano aggiungere facilmente guardrail ai loro sistemi di AI. La piattaforma di machine learning Hugging Face ha rilasciato il Chatbot Guardrails Arena, che testa la resistenza degli LLM e dei guardrail sulla privacy, per prevenire perdite di dati sensibili.

Nvidia ha creato NeMo Guardrails, un kit di strumenti open-source per aggiungere guardrail programmabili alle applicazioni basate su LLM; Guardrails AI è un pacchetto open-source simile.

LangChain, un framework per sviluppare applicazioni alimentate da LLM, offre anche una libreria di guardrail per aiutare le aziende a integrare rapidamente i guardrail nella sequenza di operazioni.

Esistono anche strumenti proprietari, come Moderation di OpenAI, che analizza il testo generato dai modelli di AI per rilevare e filtrare contenuti dannosi, inappropriati o non sicuri, secondo categorie predefinite.

Microsoft ha sviluppato un guardrail simile per monitorare il contenuto generato dai chatbot per Azure, la sua suite di servizi AI.

Come funzionano i guardrail?

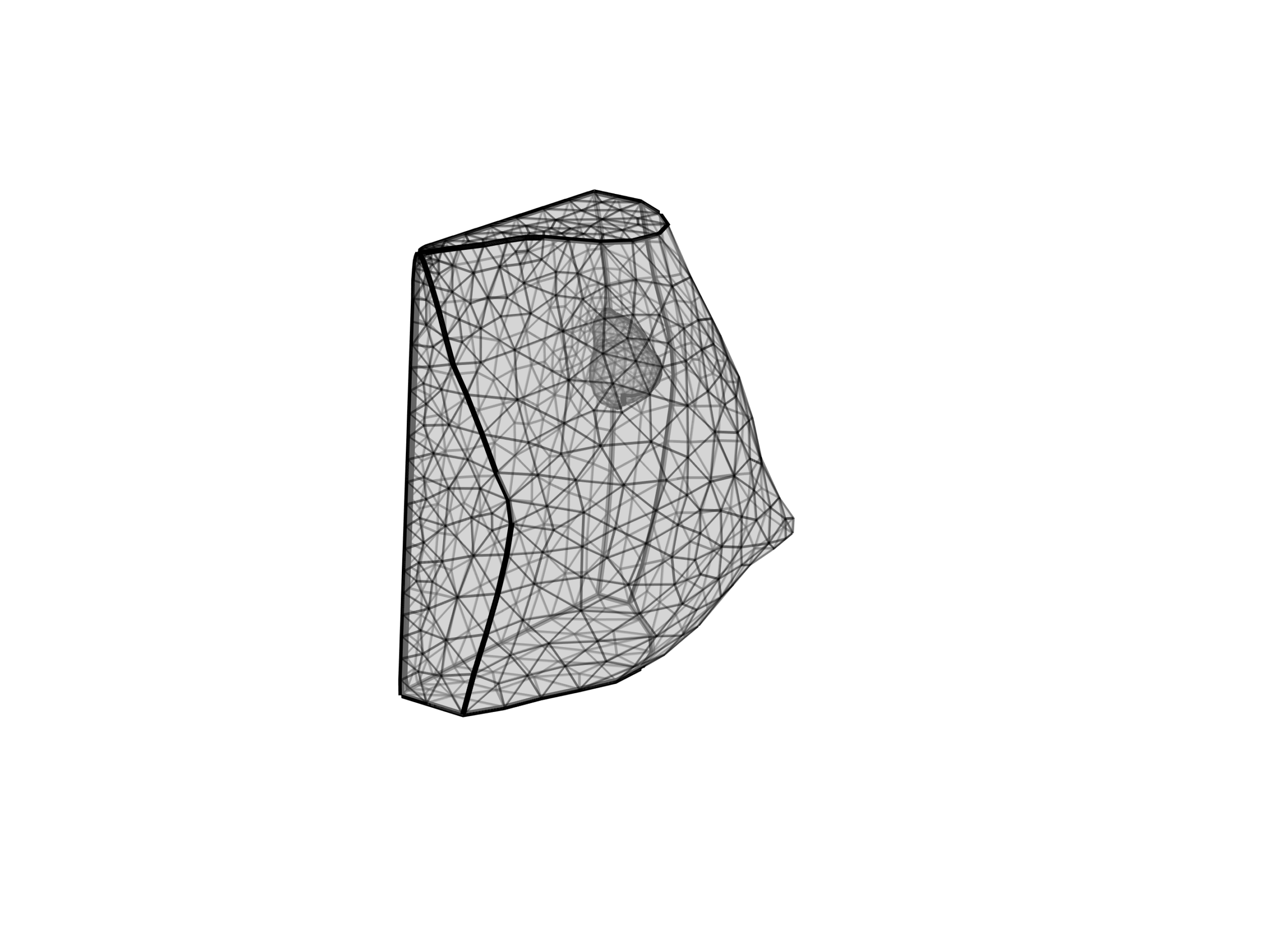

I guardrail sono costruiti utilizzando una varietà di tecniche, dai sistemi basati su regole, agli LLM; tuttavia, la maggior parte dei guardrail è completamente deterministica, il che significa che i sistemi producono sempre lo stesso output per lo stesso input, senza casualità o variabilità.

In generale, i guardrail monitorano l’output dei sistemi di AI eseguendo una serie di compiti, come classificazione, validazione semantica, rilevamento di fughe di informazioni identificabili personalmente e identificazione di contenuti dannosi.

I componenti principali

Per eseguire questi compiti, i guardrail dell’AI sono composti da quattro componenti interconnessi, ciascuno delle quali svolge un ruolo cruciale:

- Checker: il checker scansiona il contenuto generato dall’AI per rilevare errori e segnala eventuali problemi, come linguaggio offensivo o risposte parziali; agisce come prima linea di difesa, identificando problemi potenziali prima che possano causare danni o violare linee guida etiche.

- Corrector: una volta che il checker ha identificato un problema, il corrector affina, corregge e/o migliora l’output dell’AI, se necessario. Può correggere imprecisioni, rimuovere contenuti inappropriati e garantire che la risposta sia, oltre che precisa, anche allineata con il messaggio desiderato. Il corrector lavora in modo iterativo, perfezionando il contenuto fino a quando non soddisfa gli standard richiesti.

- Rail: il rail gestisce l’interazione tra il checker e il corrector: esegue controlli sul contenuto e, se il contenuto non soddisfa uno standard, attiva il corrector per apportare le modifiche. Questo processo viene ripetuto fino a quando il contenuto supera tutti i controlli o raggiunge un limite predefinito di correzioni; il rail tiene anche traccia dei processi del checker e del corrector, fornendo dati per ulteriori analisi.

- Guard: il guard interagisce con tutti e tre gli altri componenti, avviando checker e corrector insieme al rail, coordinando e gestendo il rail, aggregando i risultati dal rail e fornendo i messaggi corretti.

Conclusioni

Gli agenti AI stanno anche emergendo come strumenti che possono funzionare come guardrail, per controllare e correggere automaticamente i contenuti prodotti dagli LLM segnalati dai guardrail. I primi modelli di agenti AI possono monitorare, regolare e regolare autonomamente i contenuti generati dall’AI, come fanno gli altri guardrail dell’AI.

L’ascesa rapida dell’AI ha reso disponibili enormi opportunità, ma ha anche complicato la gestione della conformità per tutte quelle aziende che lavorano con la tecnologia; tuttavia, i guardrail possono aiutare tali aziende ad anticipare i rischi correlati e creare uno spazio più sicuro per l’innovazione e la trasformazione legata all’AI generativa. Sebbene possa sembrare che tutti questi passaggi e cambiamenti possano rallentare le attività per un’azienda, in realtà sono progettati per aiutare le organizzazioni a gestire meglio le crisi legate all’AI e, si spera, a evitarle del tutto. In futuro, ci si aspetta non solo nuovi tipi di sistemi AI, ma anche nuovi standard su come questi sistemi vengono sviluppati e resi operativi.